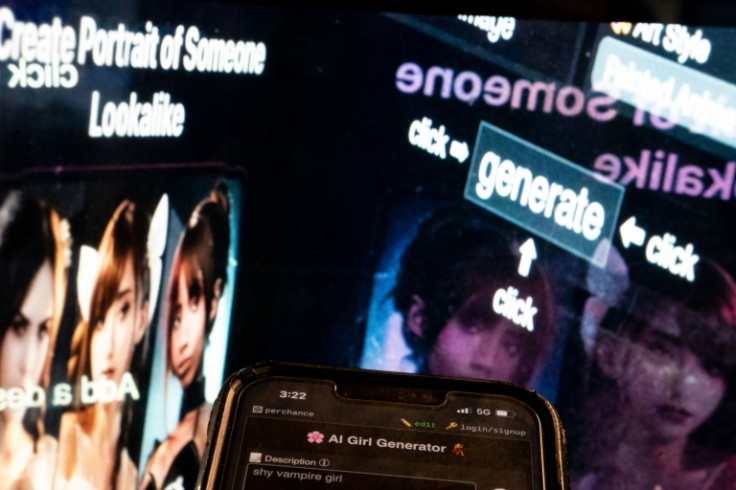

La pornographie deepfake générée par l'IA envahit les réseaux sociaux

Lorsqu'Ellis, une jeune texane de 14 ans, s'est réveillée un matin d'octobre avec plusieurs appels et SMS manqués, ils parlaient tous de la même chose : des images d'elle nue circulaient sur les réseaux sociaux.

Le fait qu'elle n'ait pas réellement pris les photos n'a pas d'importance, car l'intelligence artificielle rend les " deepfakes " de plus en plus réalistes.

Les images d'Ellis et d'un ami, également victime, ont été extraites d'Instagram, leurs visages puis placés sur les corps nus d'autres personnes. D'autres élèves, toutes des filles, ont également été ciblées, les photos composites étant partagées avec d'autres camarades de classe sur Snapchat.

"Cela avait l'air réel, comme si les corps ressemblaient à de vrais corps", a-t-elle déclaré à l'AFP. "Et je me souviens avoir eu vraiment très peur... Je n'ai jamais rien fait de tel."

À mesure que l'intelligence artificielle a explosé, la pornographie deepfake a également connu un essor, avec des images et des vidéos hyperréalistes créées avec un minimum d'effort et d'argent, ce qui a conduit à des scandales et au harcèlement dans plusieurs lycées aux États-Unis alors que les administrateurs ont du mal à réagir en l'absence de législation fédérale interdisant cette pratique. .

"Les filles pleuraient, et pleuraient toujours. Elles avaient très honte", a déclaré Anna Berry McAdams, la mère d'Ellis, qui a été choquée par le réalisme des images. "Ils ne voulaient pas aller à l'école."

Bien qu'il soit difficile de quantifier l'ampleur de l'ampleur des deepfakes, l'école d'Ellis en dehors de Dallas n'est pas la seule.

À la fin du mois, un autre scandale de faux nus a éclaté dans un lycée de l'État du New Jersey, dans le nord-est du pays.

"Cela va arriver de plus en plus souvent", a déclaré Dorota Mani, la mère d'une des victimes, également âgée de 14 ans.

Elle a ajouté qu'il n'y avait aucun moyen de savoir si des deepfakes pornographiques pouvaient circuler sur Internet à notre insu, et que les enquêtes n'étaient souvent ouvertes que lorsque les victimes s'exprimaient.

"Tant de victimes ne savent même pas qu'il y a des photos, et elles ne pourront pas se protéger, parce qu'elles ne savent pas contre quoi."

Dans le même temps, disent les experts, la loi a mis du temps à rattraper la technologie, même si des versions plus grossières de fausse pornographie, souvent axées sur des célébrités, existent depuis des années.

Mais désormais, quiconque a publié quelque chose d'aussi innocent qu'une photo sur LinkedIn peut être une victime.

"Tous ceux qui travaillaient dans cet espace savaient, ou auraient dû savoir, qu'il allait être utilisé de cette manière", a déclaré à l'AFP Hany Farid, professeur d'informatique à l'Université de Californie à Berkeley.

Le mois dernier, le président Joe Biden a signé un décret sur l'IA, appelant le gouvernement à créer des garde-fous " contre la production de matériel pédopornographique et contre la production d'images intimes non consensuelles d'individus réels ".

Et s'il s'est avéré difficile dans de nombreux cas de retrouver les créateurs individuels de certaines images, cela ne devrait pas empêcher les sociétés d'IA qui les produisent ou les plateformes de médias sociaux sur lesquelles les photos sont partagées d'être tenues pour responsables, explique Farid.

Mais il n'existe aucune législation nationale restreignant la fausse pornographie, et seule une poignée d'États ont adopté des lois la réglementant.

"Bien que votre visage ait été superposé à un corps, celui-ci ne vous appartient pas vraiment", a déclaré Renee Cummings, éthicienne de l'IA.

Cela peut créer une "contradiction dans la loi", a déclaré à l'AFP le professeur de l'Université de Virginie, car on peut affirmer que les lois existantes interdisant la diffusion de photos sexuelles d'une personne sans son consentement ne s'appliquent pas aux deepfakes.

Et tandis que " n'importe qui possédant un smartphone et quelques dollars " peut prendre ces images, à l'aide d'un logiciel largement disponible, de nombreuses victimes, qui sont principalement des jeunes femmes et des filles, " ont peur de les rendre publiques ".

La pornographie deepfake "peut détruire la vie de quelqu'un", a déclaré Cummings, citant des victimes qui ont souffert d'anxiété, de dépression et de troubles de stress post-traumatique.

Au Texas, Ellis a été interrogé par la police et les responsables de l'école. Mais les systèmes éducatif et judiciaire semblent pris au dépourvu.

"Cela me brise de constater que nous n'avons pas de mesures en place pour dire : 'Oui, c'est de la pornographie juvénile'", a déclaré Berry McAdams, sa mère.

La camarade de classe derrière les photos d'Ellis a été temporairement suspendue, mais Ellis – qui se décrivait auparavant comme sociable et extravertie – reste " constamment remplie d'anxiété " et a demandé à changer d'école.

"Je ne sais pas combien de personnes auraient pu sauvegarder les photos et les envoyer. Je ne sais pas combien de photos il a prises", dit-elle.

"Tant de gens auraient pu les obtenir."

Sa mère, quant à elle, s'inquiète de savoir si – ou, compte tenu de la longévité d'Internet, quand – les photos pourraient refaire surface.

"Cela pourrait les affecter pour le reste de leur vie", dit-elle.

© Copyright AFP 2025. All rights reserved.