Apprendre à oublier ? Comment maîtriser un chatbot malveillant

Lorsque le politicien australien Brian Hood a remarqué que ChatGPT disait aux gens qu'il était un criminel reconnu coupable, il a emprunté la voie à l'ancienne et a menacé de poursuites judiciaires contre le créateur du chatbot IA, OpenAI.

Son cas soulève un problème potentiellement énorme avec de tels programmes d'IA : que se passe-t-il lorsqu'ils se trompent d'une manière qui cause des dommages réels ?

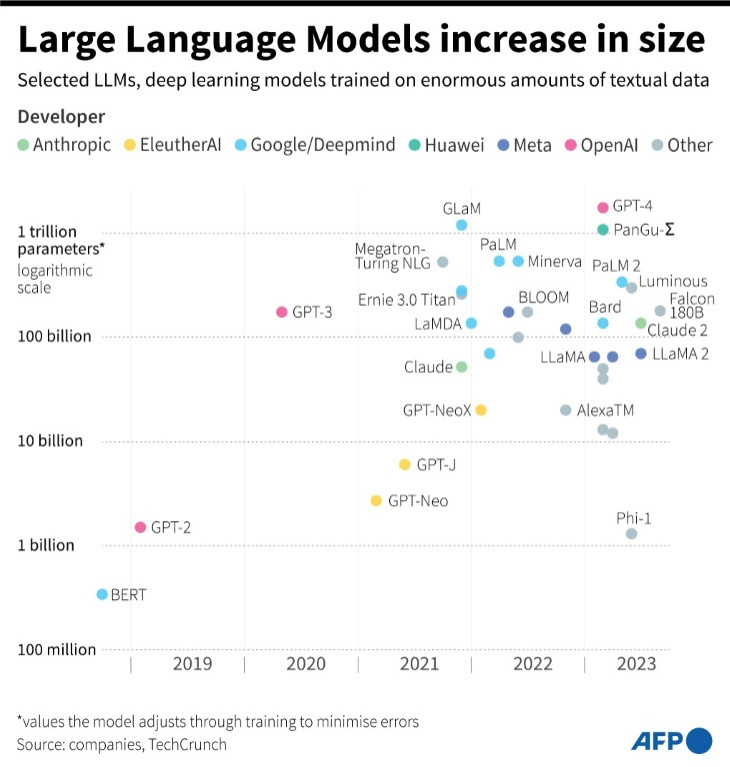

Les chatbots sont basés sur des modèles d'IA formés sur de grandes quantités de données et leur recyclage est extrêmement coûteux et prend beaucoup de temps, c'est pourquoi les scientifiques recherchent des solutions plus ciblées.

Hood a déclaré avoir parlé à OpenAI qui "n'a pas été particulièrement utile".

Mais sa plainte, qui a fait la une des journaux mondiaux en avril, a été en grande partie résolue lorsqu'une nouvelle version de leur logiciel a été déployée et n'a pas renvoyé le même mensonge – bien qu'il n'ait jamais reçu d'explication.

"Ironiquement, la grande quantité de publicité reçue par mon histoire a en fait rectifié les faits", a déclaré cette semaine à l'AFP Hood, maire de la ville de Hepburn, dans l'État de Victoria.

OpenAI n'a pas répondu aux demandes de commentaires.

Hood a peut-être eu du mal à faire valoir une accusation de diffamation, car on ne sait pas combien de personnes pourraient voir des résultats dans ChatGPT ou même si elles verraient les mêmes résultats.

Mais des entreprises comme Google et Microsoft adaptent rapidement leurs moteurs de recherche à la technologie de l'IA.

Il semble probable qu'ils seront inondés de demandes de retrait de personnes comme Hood, ainsi que de violations du droit d'auteur.

S'ils peuvent supprimer des entrées individuelles de l'index d'un moteur de recherche, les choses ne sont pas si simples avec les modèles d'IA.

Pour répondre à ces problèmes, un groupe de scientifiques est en train de forger un nouveau domaine appelé " désapprentissage automatique " qui tente d'entraîner les algorithmes à " oublier " les morceaux de données offensants.

Un expert en la matière, Meghdad Kurmanji, de l'université de Warwick en Grande-Bretagne, a déclaré à l'AFP que le sujet avait commencé à susciter un réel intérêt au cours des trois ou quatre dernières années.

Parmi ceux qui en ont pris note se trouve Google DeepMind, la branche IA du géant californien d'un billion de dollars.

Les experts de Google ont co-écrit un article avec Kurmanji publié le mois dernier qui proposait un algorithme pour nettoyer certaines données de grands modèles de langage – les algorithmes qui sous-tendent ChatGPT et le chatbot Bard de Google.

Google a également lancé en juin un concours permettant à d'autres d'affiner les méthodes de désapprentissage, qui a jusqu'à présent attiré plus de 1 000 participants.

Kurmanji a déclaré que le désapprentissage pourrait être un " outil très intéressant " permettant aux moteurs de recherche de gérer les demandes de retrait en vertu des lois sur la confidentialité des données, par exemple.

Il a également déclaré que son algorithme avait obtenu de bons résultats aux tests visant à supprimer le matériel protégé par le droit d'auteur et à corriger les biais.

Cependant, les élites de la Silicon Valley ne sont pas toutes enthousiastes.

Yann LeCun, responsable de l'IA chez Meta, propriétaire de Facebook, qui investit également des milliards dans la technologie de l'IA, a déclaré à l'AFP que l'idée du désapprentissage automatique figurait loin dans sa liste de priorités.

"Je ne dis pas que c'est inutile, inintéressant ou faux", a-t-il déclaré à propos de l'article rédigé par Kurmanji et d'autres. "Mais je pense qu'il y a des sujets plus importants et plus urgents."

LeCun a déclaré qu'il s'efforçait de permettre aux algorithmes d'apprendre plus rapidement et de récupérer les faits plus efficacement plutôt que de leur apprendre à oublier.

Mais il semble y avoir une large acceptation dans le monde universitaire du fait que les entreprises d'IA devront pouvoir supprimer des informations de leurs modèles pour se conformer à des lois telles que le règlement européen sur la protection des données (RGPD).

"La possibilité de supprimer des données des ensembles de formation est un aspect essentiel pour l'avenir", a déclaré Lisa Given de l'Université RMIT de Melbourne en Australie.

Cependant, elle a souligné qu'on ignorait tellement de choses sur la manière dont les modèles fonctionnaient - et même sur les ensembles de données sur lesquels ils étaient formés - qu'une solution pourrait être encore loin.

Michael Rovatsos, de l'Université d'Édimbourg, pourrait également constater l'apparition de problèmes techniques similaires, en particulier si une entreprise était bombardée de demandes de retrait.

Il a ajouté que le désapprentissage ne résolvait en rien les questions plus larges concernant l'industrie de l'IA, comme la façon dont les données sont collectées, qui profite de leur utilisation ou qui assume la responsabilité des algorithmes qui causent des dommages.

"La solution technique n'est pas la panacée", a-t-il déclaré.

Alors que la recherche scientifique en est à ses balbutiements et que la réglementation est quasiment inexistante, Brian Hood – qui est un fan de l'IA malgré son expérience avec ChatGPT – a suggéré que nous étions encore à l'ère des solutions démodées.

"Quand il s'agit de ces chatbots qui génèrent des déchets, les utilisateurs n'ont qu'à tout vérifier", a-t-il déclaré.

© Copyright AFP 2025. All rights reserved.